انتخاب NVIDIA H100: مقایسه PCIe، SXM و NVL برای پروژههای AI و LLM

انتخاب بین مدلهای مختلف NVIDIA H100 فقط یک خرید سختافزاری نیست؛ یک تصمیم معماری است که میتواند مسیر کل پروژه هوش مصنوعی شما را تعیین کند. تفاوت بین H100 PCIe، H100 SXM و H100 NVL مستقیماً روی مقیاسپذیری، هزینه زیرساخت، مصرف انرژی و حتی امکان اجرای مدلهای زبانی بزرگ (LLM) اثر میگذارد.

برای پروژه من، کدام مدل H100 انتخاب درستی است؟

اگر به دنبال دید کلی درباره GPUهای دیتاسنتری NVIDIA هستید، به مقاله زیر مراجعه کنید:

راهنمای جامع کارت گرافیکهای دیتاسنتری NVIDIA برای AI و LLM

این راهنما برای کاربران عمومی نوشته نشده است. مخاطب این مقاله:

- CTO و مدیران فنی

- مهندسان AI و ML

- مدیران دیتاسنتر و زیرساخت

- تیمهایی که قصد آموزش یا سرویسدهی مدلهای هوش مصنوعی در مقیاس بالا دارند

اگر تصمیم شما صرفاً «خرید یک GPU قویتر» است، این مقاله مناسب شما نیست. اینجا درباره تناسب GPU با پروژه صحبت میکنیم.

تفاوت H100 PCIe، SXM و NVL در یک نگاه فنی

تمام مدلهای H100 بر پایه معماری Hopper ساخته شدهاند. تفاوت اصلی آنها نه در قدرت خام، بلکه در این سه محور است:

- نوع رابط اتصال (PCIe یا SXM)

- نحوه ارتباط بین چند GPU (NVLink)

- الزامات زیرساختی (برق، خنکسازی، شاسی سرور)

در عمل، همین تفاوتها مشخص میکند که یک مدل H100 برای پروژه شما مناسب است یا تبدیل به هزینه اضافی میشود.

مدلهای اصلی H100

| مدل | رابط | حافظه | توان مصرفی | توضیحات |

|---|---|---|---|---|

| H100 SXM5 80GB | SXM5 | ۸۰ گیگابایت HBM3 | حدود ۷۰۰ وات | قدرتمندترین نسخه، طراحیشده برای سرورهای حرفهای دیتاسنتر |

| H100 PCIe 80GB | PCIe | ۸۰ گیگابایت HBM3 | حدود ۳۵۰ وات | نسخه سازگار با معماری سرورهای استاندارد |

| H100 NVL (دو GPU) | PCIe (دو کارت) | ۲ × ۹۴ گیگابایت HBM3 | حدود ۷۰۰ وات (مجموع) | طراحیشده مخصوص مدلهای زبانی بزرگ (LLM) و چتباتها مانند GPT |

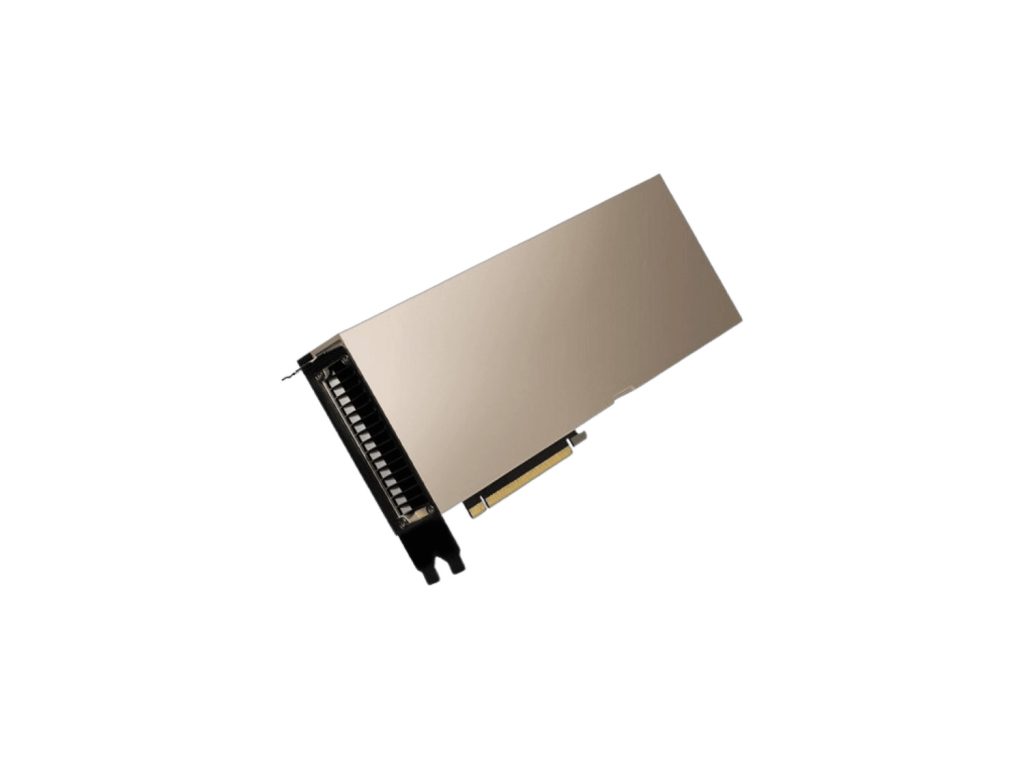

H100 PCIe؛ انتخاب متعادل برای پروژههای AI در مقیاس متوسط

H100 PCIe انعطافپذیرترین عضو خانواده H100 است. این مدل برای سرورها و شاسیهای استاندارد طراحی شده و نیاز به زیرساخت اختصاصی دیتاسنتری ندارد.

چه زمانی H100 PCIe انتخاب درستی است؟

- پروژههای AI در مقیاس کوچک تا متوسط

- تیمهای تحقیقاتی و استارتاپها

- محیطهایی که امکان تغییر معماری سرور محدود است

محدودیتهای H100 PCIe

- پهنای باند کمتر نسبت به نسخه SXM

- مقیاسپذیری محدودتر در سناریوهای چند GPU هماهنگ

- کارایی پایینتر در آموزش LLMهای بسیار بزرگ

اگر پروژه شما هنوز وارد فاز مدلهای زبانی عظیم نشده، PCIe معمولاً منطقیترین نقطه شروع است.

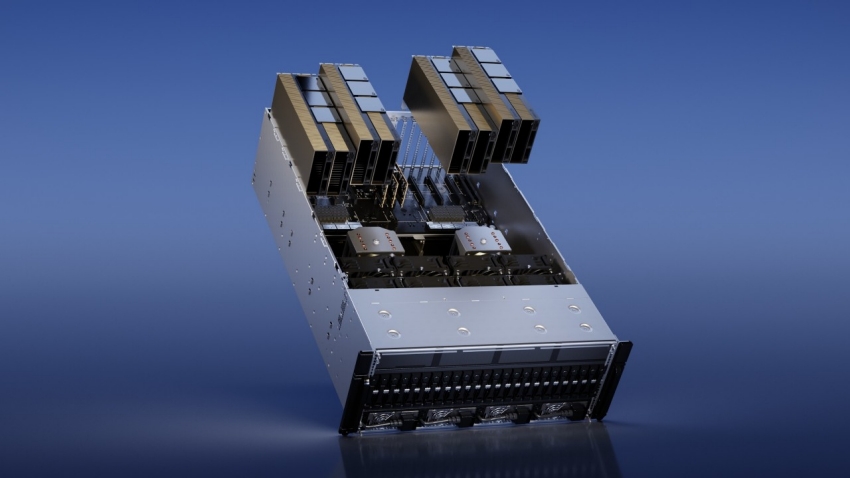

H100 SXM؛ حداکثر توان، حداکثر الزام زیرساخت

H100 SXM برای دیتاسنترهای حرفهای ساخته شده است. این مدل از طریق ماژول SXM به مادربرد متصل میشود و بالاترین پهنای باند حافظه و ارتباط بین GPUها را ارائه میدهد.

چه زمانی H100 SXM معنا پیدا میکند؟

- آموزش مدلهای زبانی بزرگ (LLM) در مقیاس بالا

- استفاده همزمان از چند GPU با NVLink

- دیتاسنترهایی با برق و خنکسازی صنعتی

چه زمانی SXM انتخاب اشتباه است؟

- زیرساخت سروری استاندارد

- محدودیت جدی در توان برق یا خنکسازی

- پروژههایی که از مزایای NVLink استفاده نمیکنند

SXM قدرتمندترین نسخه H100 است، اما فقط زمانی که زیرساخت شما آماده باشد.

H100 NVL؛ راهکار تخصصی برای LLMهای بسیار بزرگ

H100 NVL یک GPU ساده نیست؛ یک راهکار Dual-GPU است که دو H100 را با ارتباط NVLink در یک پکیج ارائه میدهد. این مدل بهطور خاص برای بارهای کاری LLM طراحی شده است.

مزیت اصلی H100 NVL

- حافظه مؤثر بسیار بالا

- کاهش گلوگاه حافظه در مدلهای بزرگ

- مناسب برای چتباتها و مدلهای مولد بزرگ

چه زمانی NVL انتخاب اشتباه است؟

- مدلهایی که در حافظه یک GPU جا میشوند

- پروژههایی با محدودیت شدید زیرساخت

- زمانی که هزینه زیرساخت از سود پروژه بیشتر میشود

NVL زمانی معنا دارد که پروژه شما واقعاً با محدودیت حافظه روبهرو باشد، نه صرفاً به دنبال قویترین گزینه بازار.

کدام H100 برای چه پروژهای؟

| نوع پروژه | مدل پیشنهادی H100 | دلیل انتخاب | چه زمانی نکنیم |

|---|---|---|---|

| AI متوسط / تحقیقاتی | PCIe | انعطافپذیر، هزینه کمتر | LLMهای بسیار بزرگ |

| آموزش LLM بزرگ | SXM | NVLink و پهنای باند بالا | نبود زیرساخت مناسب |

| LLM بسیار بزرگ / سرویسدهی سنگین | NVL | حافظه مؤثر بالا | مدلهای کوچکتر |

این جدول مهمترین بخش تصمیمگیری است. مشخصات فنی بهتنهایی راهنما نیستند؛ سناریوی استفاده تعیینکننده است.

اشتباهات رایج در انتخاب H100

- انتخاب SXM بدون زیرساخت مناسب

- استفاده از NVL برای پروژههایی که حافظه بالا نیاز ندارند

- تمرکز روی عدد و مشخصات بهجای بار کاری واقعی

- نادیده گرفتن هزینه برق، خنکسازی و ارتقا

بیشتر هزینههای اضافی پروژههای AI از همین اشتباهات ناشی میشود.

نکته مهم درباره NVIDIA و برندهای سازنده

انویدیا طراحی معماری و چیپست GPU را انجام میدهد، اما تولید نهایی کارتها و سرورها توسط شرکتهایی مانند ASUS، Gigabyte، Dell، HPE و سایر سازندگان دیتاسنتری انجام میشود.

به همین دلیل ممکن است یک مدل H100 با برندهای مختلف در بازار دیده شود، اما هسته پردازشی، معماری و قابلیتهای فنی آنها یکسان است. تفاوتها معمولاً در شاسی سرور، سیستم خنکسازی، پاور و پشتیبانی سازمانی دیده میشود، نه در خود GPU.

جمعبندی نهایی

NVIDIA H100 یک GPU واحد نیست؛ یک خانواده با سناریوهای کاملاً متفاوت است.

انتخاب درست بین PCIe، SXM و NVL یعنی تطبیق GPU با پروژه، نه خرید قویترین مدل بازار.

برای تصمیمگیری کلان در انتخاب GPUهای دیتاسنتری و مقایسه با سایر نسلها، مقاله زیر از مجله شبکه ارغوان را مطالعه کنید:

راهنمای جامع کارت گرافیکهای دیتاسنتری NVIDIA برای AI و LLM

سوالات متداول درباره انتخاب NVIDIA H100

1. تفاوت عملی H100 PCIe، SXM و NVL در پروژههای AI چیست؟

تفاوت اصلی در مقیاسپذیری، نیاز زیرساخت و نوع بار کاری است.

PCIe برای سرورهای استاندارد و پروژههای AI در مقیاس متوسط مناسب است، SXM برای آموزش LLMهای بزرگ با چند GPU هماهنگ طراحی شده و NVL یک راهکار Dual-GPU است که برای مدلهای زبانی بسیار بزرگ با گلوگاه حافظه استفاده میشود.

2. برای آموزش مدلهای زبانی بزرگ (LLM)، SXM بهتر است یا NVL؟

اگر گلوگاه اصلی شما ارتباط بین چند GPU و پهنای باند است و زیرساخت دیتاسنتری مناسب دارید، SXM انتخاب منطقیتری است.

NVL زمانی بهتر است که محدودیت حافظه مشکل اصلی باشد و مدل در حافظه یک GPU جا نشود. انتخاب بین این دو کاملاً به نوع گلوگاه پروژه بستگی دارد.

3. آیا انتخاب H100 PCIe برای پروژههای AI تصمیم اشتباهی است؟

خیر. در بسیاری از پروژههای AI، H100 PCIe بهترین نقطه تعادل بین هزینه، کارایی و انعطافپذیری است.

اگر پروژه شما هنوز وارد فاز LLMهای بسیار بزرگ نشده و زیرساخت استاندارد دارید، PCIe نهتنها اشتباه نیست، بلکه انتخاب منطقیتری نسبت به SXM یا NVL است.

4. چه زمانی H100 NVL انتخاب اشتباه محسوب میشود؟

زمانی که مدل شما در حافظه یک GPU جا میشود یا زیرساخت لازم برای مصرف برق و خنکسازی NVL را ندارید.

در این شرایط، NVL فقط هزینه زیرساخت را افزایش میدهد بدون اینکه بازده واقعی ایجاد کند.

5. آیا میتوان بعداً از H100 PCIe به SXM یا NVL ارتقا داد؟

در اغلب موارد خیر. SXM و NVL به شاسی سرور، پاور و سیستم خنکسازی متفاوتی نیاز دارند.

اگر از ابتدا زیرساخت با دید ارتقا طراحی نشده باشد، تغییر از PCIe به SXM یا NVL معمولاً با هزینه بالا یا بنبست فنی همراه میشود.